十九. 机器学习 DRAFT

一、机器学习简介

机器学习是一种人工智能的分支,其主要目标是让计算机系统能够从数据中学习和改进,而不需要明确地进行编程。通过机器学习算法,计算机系统可以根据数据模式和趋势进行预测和决策,从而实现自主学习和自我优化的能力。

机器学习可以分为监督学习、无监督学习和强化学习等不同的类型。监督学习是指通过已有的标注数据来训练模型,无监督学习则是在没有标注数据的情况下让模型自行学习数据的结构和模式,而强化学习则是通过试错的方式来训练模型,以获得最佳的行为策略。

机器学习在各个领域都有着广泛的应用,包括自然语言处理、图像识别、医疗诊断、金融风险评估等。随着数据量的不断增加和算法的不断进步,机器学习正在成为推动人工智能发展的重要驱动力之一。

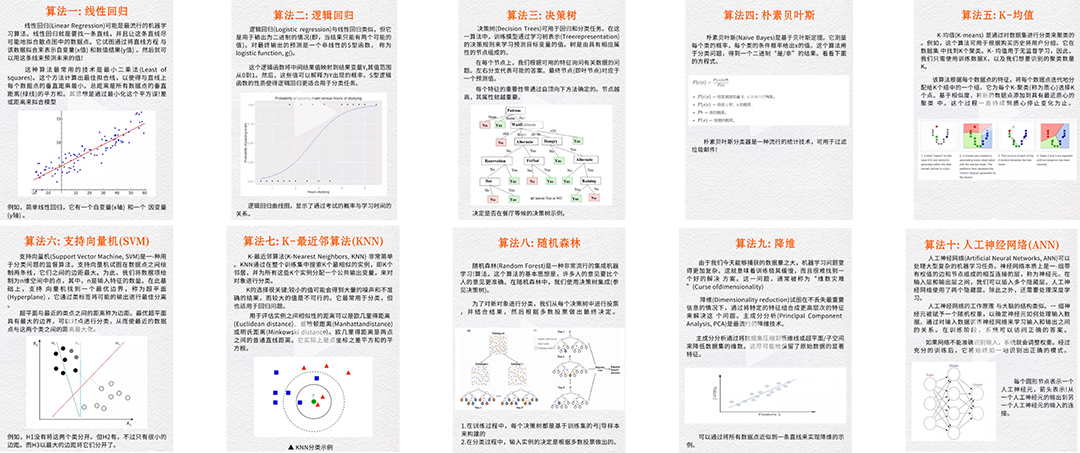

十个需要知道的算法

1.1 什么是机器学习

机器学习是一种人工智能领域的技术,通过分析和识别数据模式,使计算机系统能够自动学习并改进性能,而无需明确编程。通过训练模型来预测未来的结果或行为,机器学习可以应用于各种领域,如语音识别、图像识别、自然语言处理、推荐系统等。常见的机器学习算法包括监督学习、无监督学习、强化学习等。

1.2 机器学习的发展历史

机器学习是人工智能领域的一个重要分支,其发展历史可以追溯到上世纪50年代。以下是机器学习的主要发展历史:

-

1950s-1960s:机器学习的起源可以追溯到上世纪50年代,当时科学家们开始研究如何让计算机模拟人类的学习过程。在这个阶段,最早的机器学习算法包括感知器和逻辑回归等。

-

1970s-1980s:在这个阶段,机器学习开始受到更多关注,出现了一些经典的算法,如支持向量机(SVM)和决策树。同时,专家系统也开始兴起,成为当时机器学习的主要研究方向之一。

-

1990s-2000s:随着计算机硬件性能的提升和数据量的增加,机器学习开始蓬勃发展。这个阶段出现了一些重要的算法,如神经网络和随机森林等。同时,统计学习也成为机器学习的一个重要分支。

-

2010s至今:进入21世纪后,机器学习得到了前所未有的发展。深度学习作为一种新型的机器学习方法,以其强大的学习能力和广泛的应用场景受到了广泛关注。同时,大数据和云计算等新技术的发展也为机器学习的进一步发展提供了技术支持。

总的来说,机器学习经历了从简单的感知器到复杂的深度学习的演变过程,其发展历程充满了不断的探索和创新。随着人工智能技术的不断发展,机器学习的应用范围将会越来越广泛,对人类社会的发展产生越来越深远的影响。

1.3 机器学习的应用领域

机器学习在各个领域都有广泛的应用,包括但不限于:

- 自然语言处理:用于语音识别、文本分类、机器翻译等任务。

- 计算机视觉:用于图像识别、目标检测、人脸识别等任务。

- 医疗保健:用于疾病诊断、药物研发、健康管理等领域。

- 金融领域:用于信用评分、风险管理、股票预测等任务。

- 智能交通:用于交通流量预测、智能驾驶、路径规划等任务。

- 农业领域:用于农作物种植、病虫害检测、农业生产预测等任务。

- 工业领域:用于设备故障预测、生产优化、质量控制等任务。

- 零售领域:用于销售预测、推荐系统、价格优化等任务。

- 社交媒体:用于用户推荐、情感分析、内容过滤等任务。

总的来说,机器学习在各个领域都有着重要的应用,可以帮助人们更高效地处理复杂的问题,提升工作效率和生活质量。

二、机器学习的基本概念

机器学习的基本概念包括:

-

数据:机器学习的基础是数据,需要大量的数据来训练模型。

-

特征:在机器学习中,特征是描述数据的属性或特性,是模型学习的输入变量。

-

模型:机器学习模型是对数据进行学习和预测的数学表示,可以是线性模型、决策树、神经网络等。

-

训练:训练是指使用标记的数据来调整模型的参数,使模型能够从数据中学习特征和模式。

-

预测:预测是指使用训练好的模型对新数据进行预测或分类。

-

监督学习:监督学习是通过已知标签的数据来训练模型,使其能够对新数据进行预测或分类。

-

无监督学习:无监督学习是在没有标签的数据中学习隐藏的模式或结构。

-

强化学习:强化学习是通过与环境的交互来学习最优的行为策略。

-

过拟合和欠拟合:过拟合是指模型在训练数据上表现很好,但在测试数据上表现不佳,欠拟合是指模型无法捕捉数据中的模式或特征。

-

交叉验证:交叉验证是一种评估模型性能的方法,将数据集分为训练集和测试集,多次训练模型并在不同的子集上进行测试。

这些是机器学习的基本概念,理解这些概念对于深入学习和理解机器学习算法非常重要。

2.1 监督学习、无监督学习、半监督学习和强化学习

监督学习(Supervised Learning)是一种机器学习方法,其训练数据包括输入和输出对。在监督学习中,模型通过学习输入与输出之间的关系,从而能够预测新的输入对应的输出。常见的监督学习算法包括线性回归、逻辑回归、支持向量机等。

无监督学习(Unsupervised Learning)是另一种机器学习方法,其训练数据只包括输入,没有对应的输出。在无监督学习中,模型试图发现输入数据中的隐藏结构或模式。常见的无监督学习算法包括聚类、降维、关联规则挖掘等。

半监督学习(Semi-supervised Learning)是介于监督学习和无监督学习之间的一种学习方法。在半监督学习中,模型同时利用有标签和无标签的数据进行训练,从而提高模型的泛化能力和准确性。

强化学习(Reinforcement Learning)是一种通过与环境互动学习的机器学习方法。在强化学习中,模型通过尝试不同的行为来最大化累积奖励,从而学习最优的策略。常见的强化学习算法包括Q学习、深度强化学习等。强化学习在游戏、机器人控制等领域取得了许多成功应用。

2.2 训练集、测试集和验证集

在机器学习中,训练集、测试集和验证集是用来评估模型性能和泛化能力的重要数据集。

-

训练集(Training Set):训练集是用来训练模型的数据集。在训练过程中,模型通过学习训练集中的样本数据来调整参数和权重,以使模型能够准确地预测或分类未知数据。通常,训练集占总数据集的大部分比例,例如70%或80%。

-

测试集(Test Set):测试集是用来评估模型性能的数据集。在训练模型后,我们需要用测试集来验证模型的泛化能力,即模型是否能够准确地预测未知数据。通常,测试集占总数据集的一小部分比例,例如20%或30%。

-

验证集(Validation Set):验证集是用来调整模型超参数和选择最佳模型的数据集。在训练过程中,我们可以使用验证集来评估模型的性能,并根据验证集的表现来调整模型的超参数,以提高模型的性能。验证集通常用于避免模型的过拟合和欠拟合问题。

总的来说,训练集用来训练模型,测试集用来评估模型的性能,验证集用来调整模型的超参数和选择最佳模型。通过合理划分和使用这些数据集,可以帮助我们构建准确且泛化能力强的机器学习模型。

2.3 过拟合和欠拟合

在机器学习中,过拟合和欠拟合是两种常见的问题,它们分别指的是模型在训练数据上表现过好或者过差的情况。

过拟合是指模型在训练数据上表现非常好,但在测试数据上表现很差的情况。这是因为模型过于复杂,导致学习到了训练数据中的噪声和细节,而无法泛化到新的数据上。过拟合的解决方法包括增加数据量、减少模型复杂度、正则化等。

欠拟合则是指模型在训练数据和测试数据上表现都不好的情况,这是因为模型过于简单,无法捕捉数据中的复杂关系。欠拟合的解决方法包括增加模型复杂度、增加特征、增加训练时间等。

在实际应用中,需要通过调整模型的复杂度、优化算法、特征工程等方法来避免过拟合和欠拟合问题,从而得到更好的模型性能。

2.4 损失函数和优化算法

在机器学习中,损失函数是用来衡量模型预测结果与真实标签之间的差异程度的函数。其目的是为了评估模型在训练过程中的表现,并且通过最小化损失函数来调整模型参数,使得模型能够更准确地预测未知数据。常见的损失函数包括均方误差(MSE)、交叉熵损失函数等。

优化算法是用来最小化损失函数的算法,通过迭代更新模型参数的方法来找到使损失函数最小化的最优解。常见的优化算法包括梯度下降算法(Gradient Descent)、随机梯度下降算法(Stochastic Gradient Descent)、动量优化算法(Momentum Optimization)、自适应学习率优化算法(Adagrad、RMSprop、Adam等)等。这些优化算法通过不同的方式更新模型参数,使得模型能够更快地收敛到最优解。

三、机器学习算法

3.1 线性回归

线性回归是一种用来预测连续值输出的监督学习算法。在线性回归中,我们试图找到一条直线(或者更高维的超平面),使得这条直线能够最好地拟合数据点之间的关系。具体来说,线性回归模型的目标是找到一组权重参数,使得模型的预测值与真实值之间的误差最小化。

线性回归算法通过最小化预测值与真实值之间的平方误差来学习模型的参数。这通常通过最小化损失函数来实现,常用的损失函数是均方误差(Mean Squared Error,MSE)。通过梯度下降等优化算法,可以找到最小化损失函数的参数值,从而得到最佳的线性回归模型。

线性回归算法的优点是简单易理解,计算效率高,适用于大部分连续型数据的预测。然而,线性回归也有一些局限性,比如对非线性关系的拟合效果较差,容易受到异常值的影响等。因此,在实际应用中,需要根据具体问题的特点选择合适的模型。

3.2 逻辑回归

逻辑回归是一种广泛应用于机器学习和统计学中的分类算法。它的主要目标是根据输入特征的线性组合来预测输出的二元分类结果。逻辑回归通过将线性回归模型的输出映射到一个概率值,并利用一个逻辑函数(如Sigmoid函数)将概率值转换为二元分类结果。

在逻辑回归中,我们首先通过使用训练数据集来学习模型的参数(也称为权重),以便最大化似然函数或最小化损失函数。然后,我们可以使用学习到的参数来对新的数据进行分类预测。

逻辑回归有许多优点,包括计算简单,易于解释和实现,适用于二元分类问题等。然而,它也有一些缺点,如假设特征之间的线性关系,对异常值敏感等。

总的来说,逻辑回归是一种简单而有效的分类算法,适用于许多实际问题,并且通常是机器学习中的一个重要工具。

3.3 决策树

决策树算法是一种常用的机器学习算法,它通过一系列的决策节点和叶子节点来对数据集进行分类或回归分析。在决策树算法中,每个节点代表一个属性特征,每个边代表这个属性特征的取值,而每个叶子节点代表一个类别或值。

决策树算法的主要思想是通过不断地选择最优的属性特征来构建一个树形结构,使得每个节点的子节点尽可能地纯净,即同一类别的样本尽可能地聚集在一起。在构建决策树的过程中,通常会使用一些指标来评估每个属性特征的重要性,比如信息增益、基尼系数等。

决策树算法具有很好的可解释性和易于理解的特点,同时也能够处理大规模的数据集。然而,决策树算法容易过拟合训练数据,因此通常需要进行剪枝操作来提高泛化能力。此外,决策树算法也可以与集成学习方法结合,比如随机森林和梯度提升树,以提高模型的准确性和稳定性。

例如:

假设我们要建立一个决策树来预测一个人是否会购买一件特定商品。我们收集了一些关于不同人的特征数据,比如年龄、性别、收入和购买历史等。

首先,我们需要根据这些特征数据构建一个决策树。我们可以选择一个特征作为根节点,比如年龄,然后根据不同年龄段的购买历史来划分数据集。接着,我们可以选择另一个特征作为第二个节点,比如性别,然后再次根据性别不同购买历史来划分数据集。依此类推,我们可以构建一个完整的决策树来预测一个人是否会购买这个商品。

最后,我们可以使用这个决策树来预测新的数据。比如,如果一个人的年龄在30岁以下,性别为女性,收入较高,并且曾经购买过类似商品,那么根据我们构建的决策树,这个人很可能会购买这个商品。

3.4 支持向量机

支持向量机(Support Vector Machine,SVM)是一种用于分类和回归分析的监督学习模型。它的基本原理是找到一个最优的超平面,将不同类别的数据点分隔开。这个超平面应该使得两个类别的数据点之间的间隔最大化。

具体来说,支持向量机通过找到能够最大化间隔的超平面来进行分类。在二维空间中,这个超平面可以表示为一条直线,而在更高维空间中,它可以表示为一个平面或者超平面。支持向量机的目标是找到这个超平面,并且使得所有的数据点都与这个超平面的间隔最大化。

支持向量机还有一种扩展形式,即核函数支持向量机(Kernel Support Vector Machine)。这种方法通过将数据映射到高维空间来解决线性不可分的问题,从而使得原本在低维空间中线性不可分的数据变得线性可分。

总的来说,支持向量机是一种强大的机器学习算法,适用于分类和回归问题,并且在许多实际应用中取得了很好的效果。

例如:

假设我们有一个数据集,其中包含两个类别的样本点,分别表示为红色和蓝色。支持向量机可以帮助我们找到一个最优的超平面,将这两个类别的样本点分开。例如,在二维空间中,我们可以将这个超平面看作是一条直线。

当新的样本点出现时,支持向量机可以根据这个超平面将其分类到不同的类别中。通过在训练过程中找到最大间隔超平面,支持向量机可以提高分类的准确性和泛化能力。

3.5 K近邻算法

K近邻(K-Nearest Neighbors,简称KNN)是一种基本的机器学习算法,它通过测量不同特征之间的距离来对数据进行分类或预测。KNN算法的基本思想是:如果一个样本在特征空间中的k个最相似(即距离最近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

具体来说,KNN算法的步骤如下:

- 选择合适的距离度量方法(如欧氏距离、曼哈顿距离、余弦相似度等)。

- 选择合适的K值(即选择多少个最近邻进行投票)。

- 计算待分类样本与训练集中所有样本的距离。

- 根据距离找出待分类样本的K个最近邻。

- 统计K个最近邻中各类别的出现次数,将待分类样本归为出现次数最多的类别。

- 完成分类或预测。

KNN算法的优点包括简单易懂、易于实现、无需训练过程等。但是KNN算法也存在一些缺点,比如对大规模数据集计算复杂度高、需要大量的存储空间、对异常值敏感等。

在实际应用中,KNN算法通常用于分类问题,例如对文本进行分类、对图像进行识别等。此外,KNN算法也可以用于回归问题,例如根据相似数据点的值来预测目标变量的值。

3.6 聚类算法

聚类算法是一种无监督学习方法,它将数据集中的样本分成不同的组(簇),使得同一组内的样本彼此相似,不同组之间的样本具有较大的差异性。聚类算法可以用于数据分析、数据挖掘、模式识别等领域。

在机器学习中,常见的聚类算法包括K均值聚类、层次聚类、DBSCAN、高斯混合模型等。下面对其中几种常见的聚类算法进行详细解释:

-

K均值聚类(K-means):K均值聚类是一种简单且高效的聚类算法,它将数据集分成K个簇,每个簇由离该簇中心点最近的样本组成。算法首先随机选择K个中心点,然后迭代地将每个样本分配到距离最近的中心点所对应的簇中,然后更新每个簇的中心点,直到达到收敛条件。

-

层次聚类(Hierarchical Clustering):层次聚类算法将数据集中的样本逐步合并成越来越大的簇或者从大的簇逐步细分成越来越小的簇。层次聚类可以分为凝聚型(自底向上)和分裂型(自顶向下)两种方法。凝聚型层次聚类从每个样本开始,逐步合并最接近的簇,直到达到指定的簇的数量。分裂型层次聚类从一个包含所有样本的簇开始,逐步细分成更小的簇,直到每个簇只包含一个样本。

-

DBSCAN(Density-Based Spatial Clustering of Applications with Noise):DBSCAN是一种基于密度的聚类算法,它能够发现任意形状的簇,并且能够处理噪声数据。DBSCAN算法定义了两个参数:ε(邻域半径)和MinPts(最小样本数),通过这两个参数来定义核心点、边界点和噪声点。算法首先找到一个核心点,然后将其密度可达的所有样本合并成一个簇,最后找到所有的核心点和边界点,将它们分配到相应的簇中。

-

高斯混合模型(Gaussian Mixture Model,GMM)是一种常用的聚类算法,它假设数据是由多个高斯分布混合而成的。在这个模型中,每一个高斯分布代表一个簇,而数据点则被分配到不同的簇中。

具体来说,GMM可以通过以下步骤进行建模和聚类:

- 随机初始化每个高斯分布的均值和协方差矩阵,以及每个高斯分布的权重。

- 通过Expectation-Maximization(EM)算法迭代更新每个高斯分布的参数,直到收敛。在E步骤中,计算每个数据点属于每个高斯分布的概率(后验概率);在M步骤中,根据这些后验概率更新每个高斯分布的参数。

- 根据每个数据点属于每个高斯分布的概率,将数据点分配到最可能的高斯分布中。

- 重复步骤2和步骤3,直到收敛或达到迭代次数上限。

GMM的优点包括:

- 能够对非凸形状的簇进行建模,因为它假设数据是由多个高斯分布混合而成的;

- 在数据集的分布比较复杂时,效果通常比K均值聚类更好;

- 可以估计每个数据点属于每个簇的概率,而不仅仅是硬聚类。

然而,GMM也有一些缺点:

- 对于大规模数据集而言,计算复杂度较高;

- 容易受到初始化参数的影响,可能会收敛到局部最优解;

- 需要事先确定簇的数量,这在实际应用中可能并不容易确定。

总的来说,高斯混合模型是一种强大的聚类算法,可以应用于许多不同的领域,但需要在实践中仔细调参和评估。

四、深度学习

深度学习是一种机器学习技术,其核心思想是通过模拟人类大脑神经元之间的连接方式来实现计算机的学习能力。深度学习模型通常由多个层次组成,每一层都包含多个神经元,这些神经元通过学习大量数据来自动提取特征并进行预测。

深度学习通过神经网络模型来实现,其中包括输入层、隐藏层和输出层。在训练过程中,模型通过不断调整参数来最小化损失函数,从而提高预测准确性。深度学习模型可以处理复杂的非线性关系,适用于图像识别、语音识别、自然语言处理等领域。

深度学习的优势在于能够自动提取特征,无需手动设计特征工程,大大简化了机器学习的流程。此外,深度学习模型的表现能力很强,可以逐渐提高准确率,适用于大规模数据集和复杂任务。

然而,深度学习也存在一些挑战,例如需要大量的数据和计算资源来训练模型,容易过拟合,模型可解释性较差等问题。因此,在实际应用中需要综合考虑深度学习的优缺点,并选择合适的算法和技术来解决具体问题。

4.1 神经网络的基本结构

在深度学习中,神经网络是一种模仿人脑神经元之间相互连接的结构,用于学习和识别复杂模式和关系的机器学习模型。神经网络由多个层次组成,每一层都包含多个神经元,这些神经元之间通过权重相互连接,并且每个神经元都有一个激活函数,用于对输入信号进行非线性转换。

在神经网络中,输入数据首先被传递到输入层,然后通过隐藏层逐层传递到输出层,输出层给出最终的预测结果。在神经网络的训练过程中,通过反向传播算法来不断调整神经元之间的连接权重,使得神经网络的输出结果与真实标签之间的误差最小化。

深度学习中的神经网络通常包含多个隐藏层,这样的神经网络被称为深层神经网络。通过增加隐藏层的数量,神经网络可以学习到更加复杂的模式和特征,从而提高模型的性能和泛化能力。深度学习中的神经网络已经广泛应用于图像识别、语音识别、自然语言处理等领域,并取得了许多成功的应用。

神经网络是深度学习中最基本的模型之一,它由多个神经元(节点)组成,这些神经元通过连接(权重)相互联系在一起。神经网络的基本结构包括输入层、隐藏层和输出层。

-

输入层:输入层接收原始数据,并将其传递给下一层。每个输入节点对应数据的一个特征,例如图像的像素值或文本的单词。

-

隐藏层:隐藏层是在输入层和输出层之间的一层或多层神经元。每个隐藏层都包含多个神经元,每个神经元接收上一层的输出,并将加权和传递给下一层。隐藏层的作用是将输入数据映射到更高维度的特征空间,以便更好地拟合数据的复杂关系。

-

输出层:输出层接收隐藏层的输出,并生成最终的预测结果。输出层的神经元的数量取决于问题的类型,例如分类问题可能有多个输出神经元对应不同类别的概率,回归问题可能只有一个输出神经元对应预测的数值。

在神经网络中,每个神经元都有激活函数,用于引入非线性变换,从而使神经网络能够学习非线性关系。常用的激活函数包括ReLU、Sigmoid和Tanh等。

神经网络通过反向传播算法来优化权重,使得模型的预测结果与真实标签之间的误差最小化。反向传播算法通过计算损失函数的梯度来更新神经网络中的权重,从而逐步优化模型。

总的来说,神经网络的基本结构包括输入层、隐藏层和输出层,通过反向传播算法来训练模型,从而实现对复杂数据关系的学习和预测。

4.2 深度学习的发展历程

深度学习是一种人工智能技术,模仿人类大脑的结构和功能,通过神经网络进行学习和推断。它的发展历程可以分为以下几个阶段:

-

早期神经网络:20世纪50年代,神经网络的概念首次被提出。但由于计算能力有限,神经网络的发展一直处于停滞状态。

-

反向传播算法的提出:1986年,Hinton等人提出了反向传播算法,使得神经网络的训练变得更加高效。这一突破性进展推动了神经网络的发展。

-

深度学习的复兴:2012年,Hinton等人利用深度学习技术在ImageNet图像识别竞赛中取得了巨大成功,引起了学术界和工业界对深度学习的关注和热情。

-

硬件技术的进步:随着计算机硬件技术的不断进步,如GPU的广泛应用,深度学习的训练速度大大提高,使得更加复杂的神经网络模型得以实现。

-

深度学习在各领域的应用:深度学习技术被广泛应用于计算机视觉、自然语言处理、语音识别等领域,取得了许多突破性的成果,如人脸识别、语音助手等。

-

深度学习的发展趋势:未来,深度学习将继续发展,越来越多的领域将受益于深度学习技术的应用,同时也面临着一些挑战,如模型的解释性、数据隐私等问题。

4.3 卷积神经网络(CNN)

卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习模型,特别适用于处理图像和语音数据。它的核心思想是通过卷积操作来提取输入数据中的特征,并通过池化操作减少特征图的大小,最终通过全连接层进行分类或回归。

CNN的结构通常包括以下几个部分:

-

卷积层(Convolutional Layer):卷积层是CNN的核心部分,通过在输入数据上滑动卷积核(filter)进行卷积操作,提取输入数据的特征。卷积操作可以保留空间信息,并减少参数量,使得模型更加高效。

-

激活函数(Activation Function):在卷积层之后通常会添加一个激活函数(如ReLU),用于引入非线性,增加模型的表达能力。

-

池化层(Pooling Layer):池化层用于减少特征图的大小,降低计算量,并提取特征的位置不变性。常见的池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)。

-

全连接层(Fully Connected Layer):全连接层将卷积层和池化层提取的特征进行压缩和组合,最终输出分类或回归的结果。

-

Dropout层:Dropout层用于在训练过程中随机丢弃一部分神经元,防止过拟合。

CNN在图像处理领域取得了巨大成功,可以应用于图像分类、目标检测、图像生成等任务。其优点包括对平移、尺度和旋转等变换具有一定的不变性,可以自动学习数据中的特征,并且具有较好的泛化能力。CNN在自然语言处理领域也有广泛应用,如文本分类、情感分析等任务。

举个例子,假设我们要训练一个CNN来识别手写数字。我们可以使用MNIST数据集,该数据集包含了0到9的手写数字图片。我们可以将每张图片作为模型的输入。

首先,我们通过卷积层对图片进行特征提取。卷积层会使用一系列卷积核对输入图片进行卷积操作,从而提取出不同的特征,如边缘、纹理等。

接着,通过池化层对提取的特征进行降维和抽象。池化层通常使用最大池化或平均池化来减少特征的维度,同时保留最重要的信息。

最后,我们通过全连接层将池化层的输出连接到一个输出层,该输出层对提取的特征进行分类,从而判断输入图片属于哪个数字类别。

通过反向传播算法来优化CNN的参数,使得模型能够更准确地识别手写数字。 最终,我们可以使用测试集来评估模型的性能,并对其进行调整和改进。

在下面的代码中,我们将使用 PyTorch 构建一个简单的卷积神经网络(CNN)模型来分类图像。这个例子将是一个最基础的CNN架构,适合用于识别 MNIST 数据集中的手写数字(但请注意,为了保持示例简单,下面的代码并未包含数据加载和预处理部分)。

首先,请确保你已经安装了 PyTorch。可以通过 PyTorch 官网获取安装指南:https://pytorch.org/get-started/locally/

现在,让我们来构建模型:

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 设定超参数

input_size = 28*28 # 图像的总大小为 28x28=784

hidden_size = 128 # 隐藏层的大小

num_classes = 10 # 类别数,因为是MNIST数据集,所以共有10个类别

num_epochs = 2 # 训练的总迭代周期

batch_size = 64 # 批大小

learning_rate = 0.001 # 学习速率

# CNN模型定义

class ConvNet(nn.Module):

def __init__(self, num_classes=10):

super(ConvNet, self).__init__()

self.layer1 = nn.Sequential(

nn.Conv2d(1, 16, kernel_size=5, stride=1, padding=2),

nn.BatchNorm2d(16),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.layer2 = nn.Sequential(

nn.Conv2d(16, 32, kernel_size=5, stride=1, padding=2),

nn.BatchNorm2d(32),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2))

self.fc = nn.Linear(32 * 7 * 7, num_classes)

def forward(self, x):

out = self.layer1(x)

out = self.layer2(out)

out = out.reshape(out.size(0), -1)

out = self.fc(out)

return out

model = ConvNet(num_classes)

# 损失和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

# 加载数据

# 注意这里我们并未下载MNIST数据集,这是因为 torchvision 能够帮助我们完成这一步

train_dataset = datasets.MNIST(root='./data', train=True, transform=transforms.ToTensor(), download=True)

test_dataset = datasets.MNIST(root='./data', train=False, transform=transforms.ToTensor())

train_loader = DataLoader(dataset=train_dataset, batch_size=batch_size, shuffle=True)

test_loader = DataLoader(dataset=test_dataset, batch_size=batch_size, shuffle=False)

# 训练模型

total_step = len(train_loader)

for epoch in range(num_epochs):

for i, (images, labels) in enumerate(train_loader):

# 将数据放入 GPU 设备

if torch.cuda.is_available():

images = images.cuda()

labels = labels.cuda()

# 前向传播

outputs = model(images)

loss = criterion(outputs, labels)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

if (i+1) % 100 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Step [{i+1}/{total_step}], Loss: {loss.item()}')

# 测试模型

# 测试期间不需要计算梯度(节省内存)

model.eval()

with torch.no_grad():

correct = 0

total = 0

for images, labels in test_loader:

if torch.cuda.is_available():

images = images.cuda()

labels = labels.cuda()

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total} %')以上代码定义了一个简单的CNN,它包含以下部分:

- 两个卷积层,每个后跟着一个批量归一化层、一个激活层(ReLU)和一个池化层(MaxPooling)。

- 一个全连接层,用于分类。

模型在MNIST数据集上进行了训练和测试,MNIST数据集是一组由 28 x 28 像素的手写数字组成的灰度图像。该模型期望输入的是尺寸为 28 x 28 的图像,且图像只有一个颜色通道(因为是灰度图像),这些都体现在 nn.Conv2d(1, ...) 的第一个参数中,它表示输入通道数为 1。

在训练过程中,损失函数使用了交叉熵损失,优化器使用了 Adam。

在实际使用时,需要确保数据集已经下载并放在正确的文件夹中。如果不是,datasets.MNIST 函数会尝试自动下载数据集。如果你有 GPU 设备,可以通过调用 .cuda() 方法将模型和数据移动到 GPU 以加速训练过程。

请注意,这里的代码仅供演示之用,实际应用可能需要进一步的调优和扩展。 在用于真实问题之前,可能需要进行诸如早停、学习率衰减、更复杂的数据预处理和数据增强等步骤的调整。

4.4 循环神经网络(RNN)

循环神经网络(RNN)是一种用于处理序列数据的神经网络模型。与传统的前馈神经网络不同,RNN具有循环连接,允许信息在网络中传递和保持状态。这使得RNN能够捕捉序列中的时间依赖关系,适用于处理文本、语音、时间序列等具有时间顺序性的数据。

RNN的基本结构包括一个输入层、一个隐藏层和一个输出层。在传统的RNN中,隐藏层的输出会被反馈到自身,形成循环连接。这样,网络在处理每个时间步的输入时,会考虑之前的信息,从而能够更好地理解序列数据。

RNN的计算过程可以用以下公式表示:

$h_t = f(W_h * h_t-1 + W_x * x_t + b)$

$ y_t = g(W_y * h_t + c) $

其中,$h_t$表示在时间步t的隐藏状态,$x_t$表示在时间步t的输入,$y_t$表示在时间步t的输出,f和g分别表示激活函数,$W_h$、$W_x$、$W_y$分别表示隐藏层到隐藏层、输入层到隐藏层、隐藏层到输出层的权重,b和c分别表示隐藏层和输出层的偏置。

RNN在训练过程中使用反向传播算法,通过最小化损失函数来调整网络参数,从而使得网络能够更好地预测序列数据。

然而,传统的RNN存在梯度消失和梯度爆炸等问题,导致长期依赖关系难以学习。为了解决这个问题,出现了一些改进的RNN架构,如长短时记忆网络(LSTM)和门控循环单元(GRU)等,能够更好地捕捉长期依赖关系。

循环神经网络(RNN)是一种特殊的神经网络架构,其中神经元之间的连接形成一个循环结构,使得网络可以对序列数据进行处理。在RNN中,每个时间步都有一个输入和一个输出,同时还有一个隐藏状态,用于存储网络在之前时间步的信息,并传递给下一个时间步。

RNN的计算过程可以分为以下几个步骤:

-

初始化隐藏状态:在第一个时间步,隐藏状态$h_0$通常被初始化为全零向量。

-

对于每个时间步$t$,计算隐藏状态$h_t$:

- 计算隐藏状态$h_t$的输入:将当前时间步的输入$x_t$和上一个时间步的隐藏状态$h_{t-1}$作为输入,通过权重矩阵和激活函数计算得到:

$$h_t = \text{tanh}(W_{hx}x_t + W_{hh}h_{t-1} + b_h)$$

其中,$W_{hx}$和$W_{hh}$分别是输入和隐藏状态之间的权重矩阵,$b_h$是隐藏状态的偏置项。

-

对于每个时间步$t$,计算输出$y_t$:

- 计算输出$y_t$的输入:将隐藏状态$h_t$通过权重矩阵和激活函数计算得到:

$$y_t = \text{softmax}(W_{yh}h_t + b_y)$$

其中,$W_{yh}$是隐藏状态和输出之间的权重矩阵,$b_y$是输出的偏置项,softmax函数用于将输出转化为概率分布。

-

对于每个时间步$t$,将隐藏状态$h_t$传递给下一个时间步,作为下一个时间步的输入。

通过这样的计算过程,RNN可以处理序列数据,并在每个时间步生成一个输出。 然而,传统的RNN存在梯度消失和梯度爆炸等问题,导致难以训练长序列数据。 为了解决这些问题,出现了一些改进的RNN结构,如长短时记忆网络(LSTM)和门控循环单元(GRU)。

以下是一个使用PyTorch构建的简单循环神经网络(RNN)模型的例子,它旨在处理序列数据,比如时间序列数据或文本数据。在这个简单的例子中,我们将模型应用于字符级语言模型的任务,即给定一个字符序列,模型将尝试预测下一个字符。

首先,要安装PyTorch,请跟随官方网站的指导安装适合你平台的版本(https://pytorch.org/get-started/locally/)。

然后,以下是一个简单的实现:

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

# 假设我们有一个简单的序列

text = "hello world"

# 创建字符集,并将字符映射到索引

chars = list(set(text))

char_to_index = {ch: i for i, ch in enumerate(chars)}

index_to_char = {i: ch for i, ch in enumerate(chars)}

# 构建输入序列和目标序列

input_seq = []

target_seq = []

for i in range(len(text) - 1):

input_seq.append(char_to_index[text[i]])

target_seq.append(char_to_index[text[i + 1]])

# 将输入和目标序列转换为张量

input_seq = torch.tensor(input_seq, dtype=torch.long)

target_seq = torch.tensor(target_seq, dtype=torch.long)

# 定义模型

class CharRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(CharRNN, self).__init__()

self.hidden_size = hidden_size

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x, hidden):

out, hidden = self.rnn(x, hidden)

out = out.contiguous().view(-1, self.hidden_size)

out = self.fc(out)

return out, hidden

def init_hidden(self, batch_size):

return torch.zeros(1, batch_size, self.hidden_size)

# 设置模型参数

input_size = len(chars)

hidden_size = 12

output_size = len(chars)

# 初始化模型

model = CharRNN(input_size, hidden_size, output_size)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.01)

# 添加one-hot编码

def one_hot_encode(sequence, dict_size, seq_len, batch_size):

# 初始化one-hot编码张量

features = torch.zeros(batch_size, seq_len, dict_size)

features = features.scatter_(2, sequence.unsqueeze(2), 1)

return features

# 训练模型

epochs = 100

batch_size = 1

for epoch in range(epochs):

hidden = model.init_hidden(batch_size)

model.zero_grad()

loss = 0

for i in range(input_seq.size(0)):

x = input_seq[i:i+1]

y = target_seq[i]

x = one_hot_encode(x, input_size, 1, batch_size)

output, hidden = model(x, hidden)

loss += criterion(output, y.view(-1))

loss.backward()

optimizer.step()

if epoch % 10 == 0:

print(f'Epoch {epoch} Loss: {loss.item()}')在这段代码中,我们定义了一个CharRNN类,它继承了nn.Module类。模型中有一个简单的RNN层,它接收输入并传递隐藏状态到下一时间步。我们将训练这个模型,使其能够根据给定的字符序列预测下一个字符。

我们使用了交叉熵损失函数和Adam优化器。输入序列中的每个字符都是通过one-hot编码向量化的。

注意:这个示例是非常基础的,它仅仅为了演示如何使用PyTorch构建RNN模型。 在实际应用中,对于字符级语言模型,通常会需要一个更复杂的模型(如LSTM或GRU)和更多的数据。 此外,为了更好的性能,我们一般会对整个序列执行批处理,而不是像上面的代码一样一次只处理一个数据点。

4.5 深度学习在自然语言处理中的应用

深度学习在自然语言处理中的应用非常广泛,包括但不限于文本分类、情感分析、机器翻译、语言生成、问答系统等。下面详细介绍一些常见的应用场景:

-

文本分类:深度学习可以帮助将文本数据按照不同的类别进行分类,例如将新闻文章分类为政治、经济、体育等不同类别。通过深度学习模型如卷积神经网络(CNN)或循环神经网络(RNN)等,可以提取文本中的特征并进行分类。

-

情感分析:深度学习可以帮助识别文本中的情感倾向,例如对一段评论进行情感分类为正面、负面或中性。情感分析在社交媒体监测、产品评论分析等领域有广泛的应用。

-

机器翻译:深度学习在机器翻译领域有着重要的应用,通过神经网络模型如编码-解码模型(Encoder-Decoder)等,可以实现不同语言之间的自动翻译。

-

语言生成:深度学习可以用于生成文本数据,例如生成对话、文章、诗歌等。生成模型如生成对抗网络(GAN)等可以生成逼真的文本数据。

-

问答系统:深度学习可以用于构建智能问答系统,例如通过对话生成模型或基于知识图谱的问答系统,可以回答用户提出的问题。

深度学习在自然语言处理中可以用于文本分类、情感分析、机器翻译、问答系统等任务。 下面以机器翻译为例,详细讲解深度学习在自然语言处理中的真实案例。

机器翻译是自然语言处理中的一个重要应用领域,旨在将一种语言的文本翻译成另一种语言的文本。 传统的机器翻译系统主要基于规则和统计方法,效果有限。而深度学习的出现为机器翻译带来了新的突破。

一个经典的深度学习机器翻译模型是Seq2Seq模型,它由编码器和解码器组成。 编码器将源语言的文本编码成一个固定长度的向量表示,解码器将这个向量表示解码成目标语言的文本。 编码器和解码器都是基于循环神经网络(RNN)或者注意力机制实现的。

以英语到法语的机器翻译为例,训练数据是成对的英语句子和对应的法语句子。 编码器会将英语句子的每个单词转换成一个向量表示,然后通过RNN逐步处理整个句子,得到整个句子的向量表示。 解码器以这个向量表示为输入,生成法语句子。

训练过程中,模型通过最小化目标语言与模型生成的语言之间的差异(比如交叉熵损失)来调整参数, 使得模型生成的翻译更接近真实的翻译。在训练完毕后,可以用这个模型来进行实际的翻译。

深度学习机器翻译模型在很多数据集上都取得了很好的效果,如在WMT机器翻译任务中, 深度学习模型已经超过了传统的统计机器翻译系统。

总的来说,深度学习在自然语言处理中的应用范围广泛,机器翻译只是其中之一。 随着深度学习技术的不断发展,相信在未来会有更多更先进的深度学习模型应用于自然语言处理中,带来更好的效果和更广泛的应用。

深度学习在自然语言处理(NLP)中的应用非常广泛,涵盖了语言理解和生成的大多数方面。以下是一些深度学习在NLP中的关键应用:

-

词嵌入(Word Embeddings): 词嵌入是NLP的基础,代表了将文字转化为计算机能够理解的数值形式(即向量)。深度学习模型会在一个高维空间中为每个单词生成一个向量,这些向量能够捕捉词之间的语义和语法关系。最著名的词嵌入模型包括Word2Vec、GloVe和FastText。

-

序列建模(Sequence Modeling): 多种深度学习模型能够处理文本序列,例如循环神经网络(RNN),长短时记忆网络(LSTM)和门控循环单元(GRU),它们通过记住先前的信息来处理序列数据,用于时间序列分析,文本生成等。

-

注意力机制(Attention Mechanism): 注意力机制通过让模型在处理信息时能够关注(即“注意”)序列中更有意义的部分来增强序列建模的能力。它在机器翻译和其他NLP任务中起到了关键作用。

-

变换器模型(Transformer Models): 变换器模型依赖于自注意力机制,这种结构允许模型在处理序列的任意两个位置时不需要任何中间表示。BERT、GPT系列、XLNet、T5等都是基于变换器的著名NLP模型,实现了多项NLP任务的突破性进展。

-

文本分类(Text Classification): 文本分类是指将文本归类到预定义类别中的任务,如垃圾邮件检测、情感分析或新闻分类等。深度学习模型可以自动从文本中提取特征,并进行高效分类。

-

语言模型(Language Modeling): 语言模型估计一个句子的概率,是生成性任务的基础,比如文本生成、对话系统等。深度学习语言模型例如GPT-3可以生成连贯自然的文本序列。

-

机器翻译(Machine Translation): 深度学习在机器翻译中的应用已经非常成熟,模型能够在没有规则的情况下将一种语言翻译成另一种语言,主要采用编码器-解码器(Encoder-Decoder)结构。

-

问答系统(Question Answering): 问答系统旨在从一段文本或知识库中提供给定问题的确切答案。深度学习方法可以理解自然语言问题并从相关文档中提取答案。

-

命名实体识别(Named Entity Recognition): 命名实体识别旨在识别文本中的特定实体,如人名、地点、组织等。深度学习模型能够学习从序列词汇中识别和分类这些实体的模式。

-

情感分析(Sentiment Analysis): 情感分析分析文本的情绪色彩,识别和提取其中的情感倾向。利用深度学习,可以在产品评论、社交媒体等平台上进行自动情感分析。

-

文本摘要(Text Summarization): 自动文本摘要目的是生成原文的简洁且有着重点的摘要。深度学习模型,尤其是基于变换器的结构,已经被证明在生成式和抽取式摘要上都非常有效。

这些应用只是冰山一角,深度学习在自然语言处理领域的使用仍在快速发展中,新的模型和技术不断涌现,推动着整个领域的进步。

PyTorch简单语言模型实例

要使用Python和PyTorch实现一个简单的语言模型,通常会采用一种递归神经网络(RNN)结构,例如LSTM,由于其对序列数据具有较好的性能。下面我将通过一个示例,向你展示如何搭建这样一个语言模型。这个模型将学习根据给定的一串文本生成下一个单词。

首先,需要准备数据集。为了简单起见,我们可以使用一个简单的文本文件作为我们的数据集,每一行是一句话。在真实世界的应用中,你将需要一个更大、更全面的数据集。

下面是创建一个基本的语言模型的过程:

- 数据预处理:加载语料库,创建词汇表,将单词转换成整数索引,创建输入序列和目标序列。

- 定义模型:建立一个包含嵌入层、LSTM层和全连接输出层的模型。

- 训练模型:使用一个适当的损失函数(如交叉熵损失)来训练模型。

- 文本生成:用训练好的模型生成文本。

下面是一段伪代码,它大概展示了如何完成上述步骤:

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

# 假设 corpus 是一个包含所有文本数据的字符串

corpus = "这里是你的文本数据。它可以是一本书、几个句子或一个大型的语料库。"

# 数据预处理

# 创建字典

words = corpus.split()

word_to_ix = {word: i for i, word in enumerate(set(words))}

ix_to_word = {i: word for word, i in word_to_ix.items()}

# 创建训练数据

context_size = 3 # 假设使用前3个单词预测第4个单词

data = []

for i in range(context_size, len(words)):

context = words[i - context_size:i]

target = words[i]

data.append((context, target))

# 定义模型

class LSTMModel(nn.Module):

def __init__(self, vocab_size, embed_dim, hidden_dim, context_size):

super(LSTMModel, self).__init__()

self.embeddings = nn.Embedding(vocab_size, embed_dim)

self.lstm = nn.LSTM(embed_dim, hidden_dim, batch_first=True)

self.linear = nn.Linear(hidden_dim, vocab_size)

def forward(self, input):

embeds = self.embeddings(input)

lstm_out, _ = self.lstm(embeds)

out = self.linear(lstm_out[:, -1, :])

log_probs = nn.functional.log_softmax(out, dim=1)

return log_probs

# 初始化模型

vocab_size = len(word_to_ix)

embed_dim = 128

hidden_dim = 256

model = LSTMModel(vocab_size, embed_dim, hidden_dim, context_size)

# 训练模型

loss_function = nn.NLLLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

for epoch in range(10):

total_loss = 0

for context, target in data:

# 准备输入数据

context_idxs = torch.tensor([word_to_ix[w] for w in context], dtype=torch.long)

context_idxs = context_idxs.unsqueeze(0) # 添加batch维度

target_idx = torch.tensor([word_to_ix[target]], dtype=torch.long)

# 前向传播

log_probs = model(context_idxs)

loss = loss_function(log_probs, target_idx)

# 后向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 累计损失

total_loss += loss.item()

print(f"Epoch {epoch}: Total loss {total_loss}")

# 生成文本

with torch.no_grad():

input_idxs = torch.tensor([word_to_ix[w] for w in words[:context_size]], dtype=torch.long)

input_idxs = input_idxs.unsqueeze(0) # 添加batch维度

for i in range(100): # 生成100个单词

log_probs = model(input_idxs)

_, word_idx = torch.max(log_probs, 1)

next_word = ix_to_word[word_idx.item()]

print(next_word, end=' ')

input_idxs = torch.cat((input_idxs[0, 1:], word_idx)).unsqueeze(0) # 更新输入以包含下一个单词的索引以上代码是一个基本框架,演示了如何使用PyTorch建立一个语言模型,并用于文本生成。实际应用中,你需要注意以下几点:

- 大规模和更复杂的数据集需要更好的数据预处理和更细粒度的标记化。

- 你可能需要选择不同的模型架构或超参数,具体取决于任务的目标和数据的复杂度。

- 你需要更长的训练时间和更多的数据才能获得好的生成效果。

- 文本生成时,可以使用采样策略,如温度采样或束搜索,来增加生成文本的多样性和连贯性。

这个简单的语言模型可以作为实验和学习深度学习在NLP中应用的起点。 更复杂的模型如GPT或BERT,它们是预训练的变换器模型,能够提供更高质量的文本生成能力。

五、实战项目

5.1 通过Python实现一个简单的线性回归模型

下面代码实现了一个简单的线性回归模型,可以根据输入数据X和y进行拟合,并对新的数据进行预测。

import numpy as np

class LinearRegression:

def __init__(self):

self.coef_ = None

self.intercept_ = None

def fit(self, X, y):

X = np.array(X)

y = np.array(y)

X_mean = np.mean(X)

y_mean = np.mean(y)

numerator = np.sum((X - X_mean) * (y - y_mean))

denominator = np.sum((X - X_mean) ** 2)

self.coef_ = numerator / denominator

self.intercept_ = y_mean - self.coef_ * X_mean

def predict(self, X):

X = np.array(X)

return self.coef_ * X + self.intercept_

# 使用示例

X = [1, 2, 3, 4, 5]

y = [2, 4, 5, 4, 5]

model = LinearRegression()

model.fit(X, y)

print("Coefficient:", model.coef_)

print("Intercept:", model.intercept_)

X_test = [6, 7, 8, 9, 10]

y_pred = model.predict(X_test)

print("Predictions:", y_pred)上面是一个简单的例子

此外,Python实现线性回归模型,可以使用多个不同的库,

但其中一个较为简单且常用的是scikit-learn库。

下面是一个演示如何使用scikit-learn实现和训练一个线性回归模型。

首先,确保已经安装scikit-learn:

pip install scikit-learn然后,以下是一段实现线性回归的代码:

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error, r2_score

import numpy as np

import matplotlib.pyplot as plt

# 生成一些简单的数据,举例说明

# 假设X是我们的特征集,y是目标值

np.random.seed(0)

X = np.random.rand(100, 1)

y = 2 + 3 * X + np.random.randn(100, 1)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建线性回归模型实例

model = LinearRegression()

# 训练模型

model.fit(X_train, y_train)

# 预测测试集上的目标值

y_pred = model.predict(X_test)

# 计算模型性能指标

mse = mean_squared_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

# 打印性能指标和模型参数

print(f'Mean squared error: {mse}')

print(f'R2 score: {r2}')

print('Coefficients:', model.coef_)

print('Intercept:', model.intercept_)

# 绘制结果

plt.scatter(X_test, y_test, color='black', label='Actual data')

plt.plot(X_test, y_pred, color='blue', linewidth=3, label='Fitted line')

plt.xlabel('X')

plt.ylabel('y')

plt.title('Linear Regression')

plt.legend()

plt.show()在上面的代码中,我们首先生成了一些简单的合成数据来模拟一个真实场景。这些数据大致遵循线性关系:y ≈ 2 + 3X + 高斯噪声。

在数据准备好之后,我们使用 train_test_split 函数将数据分为训练集和测试集。之后,我们初始化 LinearRegression 类的一个实例,然后使用训练集数据调用 fit 方法来训练模型。

模型训练完成后,我们使用 predict 方法在测试集上进行预测,并使用 mean_squared_error 和 r2_score 函数计算模型性能指标。

最后,我们输出了模型的性能指标和参数,并使用 matplotlib 绘制了测试数据和预测结果的图表。

需要注意的是,在实际应用中,可能需要对数据进行预处理,例如特征缩放、处理缺失值、编码分类特征等。而且,数据可能是从实际问题中收集来的,不是像这里一样人为生成的。此外,还可能需要针对模型的假设进行验证,例如检查残差的正态性和同方差性等。

5.2 使用深度学习框架搭建一个图像分类器

Python 中常用的深度学习框架

Python 中常用的深度学习框架有下列这些:

-

TensorFlow:由 Google 开发的开源深度学习框架,提供了灵活的工具和库,支持静态计算图和动态计算图。

-

PyTorch:由 Facebook 开发的开源深度学习框架,采用动态计算图的方式,易于使用和调试。

-

Keras:一个高级的神经网络 API,可以在 TensorFlow、PyTorch 等深度学习框架上运行,简化了模型的搭建和训练过程。

-

MXNet:一个灵活的深度学习框架,支持静态和动态计算图,并提供了多种语言的接口。

-

Caffe:一个轻量级的深度学习框架,适用于图像识别和卷积神经网络任务。

-

Theano:一个数学表达式计算库,可以用于构建和优化深度学习模型。

-

Chainer:一个基于动态计算图的深度学习框架,易于使用和扩展,支持多种神经网络模型的构建。

这些深度学习框架都有各自的特点和优势,可以根据具体需求和熟悉程度选择合适的框架进行开发和实验。

要使用深度学习框架搭建一个图像分类器,可以按照以下步骤进行:

-

准备数据集:首先需要准备一个包含大量图像样本的数据集,每个样本都需要有对应的标签,用于训练和验证分类器。

-

数据预处理:对数据集进行预处理,包括对图像进行缩放、裁剪、归一化等操作,以便于输入到深度学习模型中。

-

构建深度学习模型:选择一个合适的深度学习框架,如TensorFlow、PyTorch等,然后根据需求选择适合图像分类任务的模型结构,如卷积神经网络(CNN)。

-

定义损失函数和优化器:选择适合图像分类任务的损失函数,如交叉熵损失函数,然后选择合适的优化器,如Adam或SGD。

-

训练模型:将数据集分为训练集和验证集,使用训练集对模型进行训练,通过反向传播算法不断更新模型参数,直到模型收敛。

-

评估模型:使用验证集对训练好的模型进行评估,计算分类准确率等指标,以确定模型的性能。

-

模型调优:根据评估结果对模型进行调优,如调整模型结构、超参数等,以提高分类器的性能。

-

部署模型:将训练好的模型部署到实际应用中,可以通过API接口或集成到应用程序中进行图像分类任务。

通过以上步骤,就可以使用深度学习框架搭建一个图像分类器,并在实际应用中进行图像分类任务。

使用TensorFlow 训练一个简单的卷积神经网络

要使用Python和深度学习框架搭建一个图像分类器,可以选择多种流行的深度学习库,例如TensorFlow或PyTorch。 下面是一个展示如何使用TensorFlow(和它的高级API,Keras)构建和训练一个简单的卷积神经网络(CNN), 用于CIFAR-10数据集的图像分类。

首先,确保已经安装TensorFlow:

pip install tensorflow然后,你可以使用以下代码段来搭建和训练你的图像分类器:

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

import matplotlib.pyplot as plt

# 加载数据集

(train_images, train_labels), (test_images, test_labels) = datasets.cifar10.load_data()

# 标准化像素值

train_images, test_images = train_images / 255.0, test_images / 255.0

# 建立卷积神经网络模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

])

# 添加密集连接层

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10))

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

history = model.fit(train_images, train_labels, epochs=10,

validation_data=(test_images, test_labels))

# 评估模型

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print(f'\nTest accuracy: {test_acc}')

# 可视化训练结果

plt.plot(history.history['accuracy'], label='accuracy')

plt.plot(history.history['val_accuracy'], label = 'val_accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.ylim([0, 1])

plt.legend(loc='lower right')

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)在这个例子中,我们按照以下步骤构建了一个基本的CNN:

- 加载CIFAR-10数据集,并将数据分成训练集和测试集。

- 数据预处理:将图像像素值标准化到0到1之间。

- 搭建CNN模型:添加卷积层(

Conv2D)、池化层(MaxPooling2D)和全连接层(Dense)。 - 编译模型:我们使用

adam优化器,SparseCategoricalCrossentropy作为损失函数,并监控准确率指标。 - 训练模型:使用训练数据进行模型训练,同时在测试集上进行验证。

- 评估模型:在测试数据上评估模型性能。

- 可视化:绘制训练和验证准确率随着epoch的变化。

请注意,这个示例代码中model.fit函数中的epochs参数设置为10,这意味着模型将在整个训练集上进行10次迭代。

该参数可以根据需要进行调整,以达到更好的训练效果。

还应考虑到许多其他因素,例如是否进行数据增强、超参数的调整、选择更复杂的模型架构等, 这些都可能会提高模型的性能。此外,在处理实际问题中的数据时,可能需要进行额外的数据清理和预处理步骤。

PyTorch搭建一个图像分类器

在Python中使用PyTorch搭建一个图像分类器通常涉及以下步骤:

-

安装PyTorch: 确保您已经安装了PyTorch。如果没有,可以根据PyTorch官网的指示进行安装:http://pytorch.org/

-

准备数据集: 如果您使用的是标准的数据集(例如CIFAR-10或MNIST),可以直接通过

torchvision下载和加载它们。 -

定义模型: 创建一个继承自

torch.nn.Module的类来定义您的CNN架构。 -

定义损失函数和优化器: 选择一个适用于分类的损失函数和一个优化器来调整网络的参数。

-

训练模型: 使用训练数据集对模型进行多个迭代的训练。

-

评估模型: 在测试数据集上评估模型的性能,通常用准确率来衡量。

-

使用模型进行预测: 使用训练好的模型进行预测。

下面是一个使用PyTorch搭建和训练CIFAR-10数据集分类器的示例:

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# Step 1: 准备数据集

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

trainset = torchvision.datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4,

shuffle=True, num_workers=2)

testset = torchvision.datasets.CIFAR10(root='./data', train=False,

download=True, transform=transform)

testloader = torch.utils.data.DataLoader(testset, batch_size=4,

shuffle=False, num_workers=2)

# Step 2: 定义模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

# Step 3: 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# Step 4: 训练模型

for epoch in range(10): # 数据集多次循环

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

# 获取输入;data 是一个[inputs, labels]列表

inputs, labels = data

# 梯度归零

optimizer.zero_grad()

# 正向传播 + 反向传播 + 优化

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 打印统计信息

running_loss += loss.item()

if i % 2000 == 1999: # 每2000个小批次打印一次

print(f'[{epoch + 1}, {i + 1:5d}] loss: {running_loss / 2000:.3f}')

running_loss = 0.0

print('Finished Training')

# Step 5: 评估模型

correct = 0

total = 0

with torch.no_grad():

for data in testloader:

images, labels = data

outputs = net(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the 10000 test images: {100 * correct / total} %')在这段代码中,我们首先定义了数据的预处理步骤和加载了CIFAR-10数据集。然后,我们定义了一个简单的CNN模型(Net类)并进行了初始化。接下来,我们定义了交叉熵损失函数和SGD优化器,并进行了训练(共10个epoch)。最后,我们在测试集上对模型性能进行了评估,并输出了模型的准确率。

这只是一个入门级的分类器示例,实际项目中可能需要进行更复杂的模型设计、超参数调整、数据增强等步骤以提高模型性能。

5.3 利用聚类算法对数据进行分析和可视化

假设我们有一组包含用户信息的数据集,包括用户ID、年龄、性别、职业等信息。我们想要利用聚类算法对这些用户进行分群,并通过可视化来展示不同用户群体之间的特征差异。

首先,我们可以使用K均值聚类算法对用户数据进行分群。通过分析不同的聚类数(K值),我们可以找到最佳的聚类数,然后将用户数据分配到不同的群体中。

接下来,我们可以利用可视化工具(如matplotlib或seaborn)来展示不同用户群体的特征。例如,我们可以绘制年龄和职业之间的散点图,使用不同颜色或标记来表示不同的用户群体。这样可以直观地展示不同用户群体之间的年龄和职业分布情况。

另外,我们还可以利用聚类结果来进行用户画像的建立,比如给不同的用户群体起一个有意义的名称,并通过分析每个群体的特征来了解他们的行为习惯和需求,从而为市场营销和产品定位提供参考。

总之,利用聚类算法对数据进行分析和可视化可以帮助我们更好地理解数据的结构和特征,发现隐藏在数据中的规律和关联,为后续的决策和优化提供支持。

Python利用聚类算法对数据进行分析和可视化的例子

在Python中进行聚类分析和可视化的一个常见的例子是利用scikit-learn库来实现K-Means聚类,以及matplotlib库进行数据的可视化。下面是一个简炼的例子,展示了如何使用这些工具来对一个简单的随机生成的二维数据集进行聚类分析和结果的可视化。

首先,确保已安装必要的库:

pip install numpy matplotlib scikit-learn例子代码如下:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

from sklearn.cluster import KMeans

# 生成随机数据

X, y = make_blobs(n_samples=300, centers=4, cluster_std=0.60, random_state=0)

# 使用K-Means算法进行聚类

kmeans = KMeans(n_clusters=4)

kmeans.fit(X)

y_kmeans = kmeans.predict(X)

# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], s=50, c=y_kmeans, cmap='viridis')

centers = kmeans.cluster_centers_

plt.scatter(centers[:, 0], centers[:, 1], c='red', s=200, alpha=0.5)

plt.title('K-Means Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.show()在这个例子中,我们首先用make_blobs函数创建了一个人造的二维数据集X,以及它的真实类别y,但我们在聚类过程中并不使用真实类别y。然后实例化KMeans类,设置聚类数量n_clusters=4,并将模型拟合到数据X上。接下来使用训练好的模型对数据点进行预测,将每个点分配到最近的聚类中心。

之后进行可视化:使用scatter函数画出每个聚类的数据点,并用不同的颜色将它们区分开。

聚类中心用红色的圆点表示,alpha参数设置为0.5以便使聚类中心点半透明,从而清晰地显示在其他数据点之上。

这个例子非常基础,仅仅是聚类分析和可视化的一个入门级演示。 在实际问题中,你可能需要处理更复杂的数据集、选择适当的聚类算法和参数、进行数据预处理和特征工程等。 此外,针对高维数据可能需要使用降维技术(如PCA)以便进行有效的可视化。

5.4 PyTorch人脸识别的实例

PyTorch 是一个功能丰富的深度学习库,它可以用来构建复杂的神经网络模型,包括人脸识别系统。以下是一个简化的人脸识别的实例,使用 PyTorch 和一个流行的开源人脸识别库 —— facenet-pytorch,这个库提供了使用预训练的 Inception Resnet v1 实现的人脸识别模型。

要创建一个基本的人脸识别实例,请遵循以下步骤:

1. 安装必要的库:

首先,确保你安装了 torch, torchvision, 和 facenet-pytorch 库。

pip install torch torchvision facenet-pytorch2. 导入相关的模块:

import torch

from torchvision import transforms

from facenet_pytorch import InceptionResnetV1, MTCNN, extract_face

from PIL import Image3. 加载预训练的模型和人脸检测器:

# 如果你有可用的GPU,则可以将 device 设置为 'cuda'。

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# 创建MTCNN模块用于人脸检测。

mtcnn = MTCNN(keep_all=True, device=device)

# 实例化预训练的InceptionResnetV1用于人脸嵌入。

resnet = InceptionResnetV1(pretrained='vggface2').eval().to(device)4. 定义转换:

# 定义适用于人脸识别的图像预处理转换。

preprocess = transforms.Compose([

transforms.Resize((160, 160)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5])

])5. 加载和预处理图像:

加载一张包含人脸的图像,并使用 MTCNN 进行人脸检测。

# 加载图像。

image = Image.open("path_to_your_image.jpg")

# 检测图像中的人脸。

boxes, _ = mtcnn.detect(image)

# 如果检测到人脸,从图像中提取人脸。

if boxes is not None:

# 对于每张脸,我们要剪裁并预处理以供模型使用。

faces = []

for box in boxes:

face = extract_face(image, box, save_path=None)

face = preprocess(face).to(device)

faces.append(face)6. 人脸识别:

使用 InceptionResnetV1 生成图像的人脸嵌入向量。

# 计算所有检测到的人脸的嵌入向量。

# 请注意,这里我们计算单个人脸嵌入。

# 对于多个人脸,您必须调整代码以批量方式进行处理。

with torch.no_grad():

embeddings = []

for face in faces:

face = face.unsqueeze(0) # 添加一个批次维度。

embedding = resnet(face).cpu() # 在Resnet模型上得到嵌入,并移动到CPU。

embeddings.append(embedding)7. 比较嵌入向量:

得到嵌入向量后,你可以通过比较嵌入向量的L2距离来识别人脸是否属于数据库中的某个人。这通常通过设置阈值来完成。

这个例子提供了一个基础的人脸识别的框架。在实际的应用中,你会需要一个更复杂的系统, 它包含数据库来存储已知人脸的嵌入向量,以及识别阶段的逻辑来确定未知人脸是否匹配数据库中的某个人。 请记住,人脸识别系统也必须符合所有相关的法律和隐私标准。

5.5 YOLO 人脸检测实例

YOLO 模型特别适合实时对象检测任务,因为它速度快并且定位准确。以下是一个完整的示例,说明如何使用 Python 和 YOLOv5 进行人脸识别:

1. 安装必要的库

首先,安装 torch 和 ultralytics 的 yolov5:

pip install torch torchvision

pip install git+https://github.com/ultralytics/yolov52. 导入 YOLOv5 和其他必要的模块

import torch

from PIL import Image

# 使用 ulralytics YOLOv5 模型

from yolov5 import YOLOv5

# 你需要预训练的模型权重文件,你可以从 ultralytics 的 Github 仓库下载。例如 yolov5s.pt, yolov5m.pt 等

model_weights = 'yolov5s.pt'

# 加载模型(可能需要一些时间,因为首次使用时它将从网上下载权重文件)

face_detector = YOLOv5(model_weights, device='cpu')3. 准备你的图像数据

# 加载图像文件

image_path = 'path_to_your_image.jpg'

image = Image.open(image_path)4. 进行人脸检测

# 进行推理

results = face_detector(image)

# 结果将有 [xywh, conf, class]

results.xywh

results.conf # 置信度

results.cls # 类别5. 显示检测到的人脸

# 显示图像以及检测结果

results.show()请注意,YOLOv5 默认不包含专门用于人脸检测的预训练模型。由于 YOLOv5 是一个通用对象检测模型,你可能需要为人脸识别训练一个自定义的模型,或者找到已经对人脸数据进行训练的权重。

如果你想训练自己的模型,你需要:

- 一个包含人脸图像及其对应边界框注释的数据集。

- 使用 ultralytics YOLOv5 的定制训练流程:YOLOv5 Custom Training。

示例中提到的步骤仅为概览性质,可以更具具体需求进行调整。 在实际情况中,针对于人脸识别定制的YOLO模型将需要进行特别的训练和验证,并保证其预测效果和实际应用情况。 此外,YOLO的版本有可能更新,应当参考最新的官方文档和资源来获取正确指导。

5.6 PyTorch 实现人工神经网络(ANN)实例

人工神经网络(ANN)是机器学习中的一种建模工具,通常用于分类和回归任务。以下是一个用 Python 实现的简单的人工神经网络示例。在这个例子中,我们将使用 PyTorch,它是当前最受欢迎的深度学习框架之一。

首先,你需要确保安装了 PyTorch。你可以从 PyTorch 的官方网站上获取安装指令:PyTorch 安装向导。

以下是一个使用 PyTorch 创建并训练一个简单的前馈神经网络(feedforward neural network)的例子,假设你正在处理一个二分类问题:

注:以下代码仅用于演示目的,实际应用可能需要更多的数据预处理、模型调优和评估步骤。

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

# 定义网络结构

class SimpleANN(nn.Module):

def __init__(self, input_size, hidden_size, num_classes):

super(SimpleANN, self).__init__()

self.fc1 = nn.Linear(input_size, hidden_size)

self.relu = nn.ReLU()

self.fc2 = nn.Linear(hidden_size, num_classes)

def forward(self, x):

out = self.fc1(x)

out = self.relu(out)

out = self.fc2(out)

return out

# 实例化网络

input_size = 10 # 特征数量

hidden_size = 5 # 隐藏层节点数

num_classes = 2 # 输出层节点数,即类别数

model = SimpleANN(input_size, hidden_size, num_classes)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 创建一些模拟数据

# 假设有 100 个样本,每个样本有 10 个特征

x_train = torch.randn(100, input_size)

y_train = torch.randint(0, num_classes, (100,)) # 假设的目标值

# 训练模型

num_epochs = 500 # 训练的轮数

for epoch in range(num_epochs):

# 前向传播

outputs = model(x_train)

loss = criterion(outputs, y_train)

# 后向传播和优化

optimizer.zero_grad() # 清空过往梯度

loss.backward() # 反向传播,计算当前梯度

optimizer.step() # 根据梯度更新网络参数

# 打印每个epoch的损失

if (epoch+1) % 100 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}')这个简单的神经网络包含一个隐藏层和一个输出层,各层之间使用 ReLU 激活函数。 网络使用交叉熵损失函数和 Adam 优化算法进行训练。训练数据是随机生成的, 因此这个例子并不用于实际的分类任务,只用于展示如何构建和训练一个神经网络。 在实际应用中,你需要使用真实的数据集,并且可能需要通过实验调整隐藏层的数量、大小,以及学习率等超参数。

5.7 PCA 降维实例

机器学习中的降维是指减少数据集中变量的数量的过程,同时保持数据集中重要信息的技术。降维通常用于数据预处理阶段,以减少模型训练时间和避免维度灾难。

这里是一个使用Python的scikit-learn库进行主成分分析(PCA),这是一种常用的线性降维方法,可以帮助提取数据中的主要成分。

首先,你需要安装scikit-learn库(如果你还没有安装的话):

pip install scikit-learn以下是如何使用PCA进行降维的示例:

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

import pandas as pd

# 加载示例数据集,这里我们使用鸢尾花(iris)数据集

iris = load_iris()

X = iris.data

y = iris.target

# PCA降维

# 我们想要降至2维以便于可视化

pca = PCA(n_components=2)

# 进行PCA转换

X_r = pca.fit_transform(X)

# 结果是一个降至2维的数据集

print("Original shape:", X.shape)

print("Transformed shape:", X_r.shape)

# 我们可以查看降维后各个主成分的解释方差比,看看它们分别保留了多少信息

print("Explained Variance Ratio:", pca.explained_variance_ratio_)

# 接下来,你可以将降维后的数据用于可视化,或者作为其他机器学习模型的输入在这个例子中,PCA(n_components=2) 初始化PCA模型以将数据降至两个维度。fit_transform(X)计算降维后的值并返回转换后的数据 X_r。最后,通过打印解释方差比,可以了解每个新维度的重要性。

除了PCA之外,还有其他的降维方法,比如t-SNE(t-Distributed Stochastic Neighbor Embedding)、 LDA(Linear Discriminant Analysis)等,每种方法都有其适用场景和优缺点。 t-SNE非常适合于高维数据的可视化,LDA则除了降维外,还可以用于分类任务。 在选择降维方法时,应根据具体的数据特性和需求进行选择。

5.8 随机森林实例

随机森林(Random Forest)是一种用于分类和回归的强大的集成学习算法,它通过构建多个决策树并将它们的预测结果进行集成来提高模型的准确性和稳定性。

以下是一个使用 Python 的 scikit-learn 库实现随机森林分类器的例子。在这个例子中,我们将使用鸢尾花 (Iris) 数据集作为示例,这是一个经典的多类分类问题。

首先,确保你已安装 scikit-learn 库:

pip install scikit-learn然后,你可以使用以下代码训练一个随机森林模型并对其性能进行评估:

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report, confusion_matrix, accuracy_score

# 加载鸢尾花数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42) # 70% 训练集,30% 测试集

# 创建随机森林模型

rf = RandomForestClassifier(n_estimators=100, random_state=42) # 使用100棵树

# 在训练集上训练随机森林模型

rf.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = rf.predict(X_test)

# 评价模型性能

print("Classification Report:")

print(classification_report(y_test, y_pred))

print("Confusion Matrix:")

print(confusion_matrix(y_test, y_pred))

print("Accuracy Score:")

print(accuracy_score(y_test, y_pred))RandomForestClassifier 类用于创建随机森林模型,其中 n_estimators 参数指定了树的数量,而 random_state 用于确保每次运行代码结果的可重复性。train_test_split 函数用于把数据随机划分为训练集和测试集,以此来评估模型的效果。

最后,我们使用 classification_report 和 confusion_matrix 来评估模型在测试集上的性能,并用 accuracy_score 计算模型的准确率。这为我们提供了关于模型预测质量的详细信息。

记住,对于实际问题,你可能需要进行更复杂的数据预处理、特征选择、模型参数调优以及交叉验证等步骤, 以便构建一个更加准确和稳定的模型。

5.9 K-最近邻(K-Nearest Neighbors,KNN)算法实例

K-最近邻(K-Nearest Neighbors,KNN)算法是一种基本的分类与回归方法。在分类问题中,KNN算法根据最近的K个邻居的类别,通过多数投票来决定新数据点的类别。

下面是一个使用Python和scikit-learn库来实现KNN分类器的例子。在这个例子中,我们同样使用鸢尾花(Iris)数据集。

确保你已经安装了scikit-learn库:

pip install scikit-learn接着,使用以下代码来创建和评估一个KNN模型:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.neighbors import KNeighborsClassifier

from sklearn.metrics import classification_report, confusion_matrix, accuracy_score

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建 KNN 分类器实例

# 这里我们设定K为3

knn = KNeighborsClassifier(n_neighbors=3)

# 在训练集上训练模型

knn.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = knn.predict(X_test)

# 评估模型

print("Classification Report:")

print(classification_report(y_test, y_pred))

print("Confusion Matrix:")

print(confusion_matrix(y_test, y_pred))

print("Accuracy Score:")

print(accuracy_score(y_test, y_pred))在这个例子中,KNeighborsClassifier 类用来创建KNN模型。其中,n_neighbors 参数设定了K的值,即确定邻居的数量。一般来说,K的值需要通过交叉验证来选择得到最佳的模型性能。

train_test_split 函数将数据集随机分为两部分,通常将70%的数据用于训练,30%用于测试。然后,我们用 fit 方法在训练集上训练KNN模型,并通过 predict 方法在测试集上进行预测。

最后,我们使用 classification_report、confusion_matrix 和 accuracy_score 函数来评估KNN模型的性能。通过将预测结果和真实标签进行对比,这些评估指标能够给出关于模型性能的详细信息。

像以往一样,在实践中你可能需要进行数据标准化、最优K值的选择、以及其他数据预处理步骤,来提升模型的性能。

5.10 支持向量机(Support Vector Machine,SVM)实例

支持向量机(Support Vector Machine,SVM)是一种强大的有监督学习算法,用于分类、回归和异常值检测。下面是一个使用Python的scikit-learn库实现SVM分类器的例子。在这个例子中,我们同样使用鸢尾花(Iris)数据集。

确保你已经安装了scikit-learn库:

pip install scikit-learn接着,使用以下代码来创建和评估一个SVM模型:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import classification_report, confusion_matrix, accuracy_score

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 分割数据集为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建一个SVM分类器

# 在这个例子中我们使用RBF(径向基函数)作为核函数

svm_classifier = SVC(kernel='rbf', gamma='scale')

# 在训练集上训练SVM模型

svm_classifier.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = svm_classifier.predict(X_test)

# 评估模型性能

print("Classification Report:")

print(classification_report(y_test, y_pred))

print("Confusion Matrix:")

print(confusion_matrix(y_test, y_pred))

print("Accuracy Score:")

print(accuracy_score(y_test, y_pred))在这个例子中,SVC 类用于创建SVM模型。其中,kernel 参数指定了核函数的类型,gamma 是选择RBF核函数时影响模型性能的一个参数。gamma='scale'是scikit-learn 0.22版本引入的一个选项,用于自动调整γ值。

和前面的实例类似,train_test_split 函数用于随机划分训练数据和测试数据,fit 方法用于在训练数据上训练模型,predict 方法用于进行预测。

最后,使用 classification_report、confusion_matrix 以及 accuracy_score 来评估模型性能,输出模型在测试集上的分类报告、混淆矩阵和准确率。

在实际应用中,模型的性能可能会受到核函数选择、超参数设置(例如C和gamma)和数据预处理等因素的影响, 因此你可能需要使用网格搜索(Grid Search)和交叉验证(Cross-Validation)等技术来找到最佳参数组合, 从而优化SVM模型的性能。

六、模型评估和调优

机器学习中的模型评估和调优是确保最终模型效果达到预期并符合实际应用需求的重要步骤。以下是模型评估和调优的详细解释和实现步骤:

6.1 模型评估:

训练集与测试集:

- 数据分割:将数据集分割为训练集和测试集。常见的比例包括80%/20%或70%/30%,其中训练集用来训练模型,测试集用以评估模型的泛化能力。

- 交叉验证:为了更可靠地评估模型性能,经常采用交叉验证,特别是K折交叉验证。在K折交叉验证中,数据集被分成K个大小相等的子集,模型被训练K次,每次使用K-1个子集作为训练数据,剩下的一个子集用来评估性能。这个过程循环K次,每个子集都有一次机会作为测试集。最终性能评估将基于K次评估的平均值。

评估指标:

- 分类问题:

- 准确率(Accuracy):模型预测正确的比例。

- 精确率(Precision):被正确预测为正类的示例比例。

- 召回率(Recall):实际正类被正确预测的比例。

- F1 分数(F1 Score):精确率和召回率的调和平均值,用于度量模型的准确性。

- 混淆矩阵(Confusion Matrix):展示模型预测结果和实际标签的对比矩阵。

- ROC 曲线和 AUC 评分:反映分类模型在所有分类阈值下的效能。

- 回归问题:

- 均方误差(Mean Squared Error, MSE):预测值与实际值之差的平方的平均数。

- 均方根误差(Root Mean Squared Error, RMSE):MSE的平方根,与原数据单位相同。

- 平均绝对误差(Mean Absolute Error, MAE):预测值和实际值之差的绝对值的平均数。

- R² 分数:衡量模型预测的变异性与数据中的总变异性之间的比例。

6.2 模型调优:

超参数优化:

超参数是在训练开始之前设置的参数,它们可以通过以下方法进行调优:

- 网格搜索(Grid Search):穷举各种超参数组合,选择表现最佳的超参数。

- 随机搜索(Random Search):从超参数的分布中随机选择组合,常常比网格搜索更高效。

- 贝叶斯优化:基于贝叶斯统计的方法来选择超参数,能更快地收敛到最佳解。

- 自动化机器学习(AutoML):自动选择模型和超参数。

特征选择与工程:

- 特征选择:通过统计测试、模型系数或者特征重要性评分选出最有影响力的特征。

- 特征工程:创建新特征或转换现有特征来提升模型性能。

正则化与剪枝:

- 对于如线性模型或神经网络,可以通过L1或L2正则化来减少过拟合。

- 对于决策树或集成方法,可以通过剪枝操作来简化模型。

融合与集成:

- 模型集成:将不同的模型组合成一个强大的模型,如随机森林、梯度提升机或堆叠的集成方法(Stacking)。

- 模型融合:通过平均或加权平均等方法来组合不同模型的预测。

学习曲线:

绘制训练和验证过程中的性能表现,观察模型是否存在过拟合或未拟合的情况,调整模型的复杂度或训练策略。

早停(Early Stopping):

当在一定数量的迭代之后,验证集上的性能不再提升时停止训练,以避免过拟合。

模型评估和调优的目的是找到最适合解决特定问题的模型和超参数设置。重要的是要采用正确的评估指标,并将业务理解和目标融入模型开发和选择过程中。

6.3 交叉验证

6.4 混淆矩阵

6.5 超参数调优

6.6 模型性能评估指标的选择

七、部署与应用

7.1 将模型部署到生产环境

7.2 机器学习在实际项目中的应用案例

机器学习在实际项目中有着广泛的应用,以下是一个虚构的应用案例,帮助你理解机器学习如何在实际场景中被实施和应用。

-

项目背景:

一家电商公司希望提高网站的用户购买转化率。 公司注意到,用户在网站上花费的时间、浏览的页面数量、以及他们与特定产品交互的方式等因素可能会影响他们的购买决策。 公司决定使用机器学习来分析用户行为数据,并预测哪些用户最有可能在未来的一段时间内进行购买,从而更有效地针对这些用户实施营销策略。

-

数据收集:

首先,需要收集相关数据。这可能包括:

- 用户的基本信息,如地理位置、设备类型、消费水平。

- 用户的网站浏览历史,包括访问时间、停留时间、访问的页面。

- 用户在网站上的互动行为,如点击、搜索、浏览和购买记录。

-

数据预处理与特征工程:

业务分析师和数据工程师将需要清洗数据、处理缺失值、去除异常值和进行特征工程。可能会创造新的特征,如用户会话期间的平均停留时间,或者用户与特定类别产品交互的次数等。

-

模型开发:

数据科学家将使用这些数据来训练不同的机器学习模型,例如随机森林、梯度提升机(GBM)、神经网络等,来预测用户的购买概率。这一步骤还包括交叉验证、参数调优和模型评估等,以确定哪一个或哪一组模型最适合这个任务。

-

模型部署与监控:

选定的模型通过评审之后将被部署到生产环境中。这可能涉及到将模型封装进一个 API,使它能够接收实时数据并返回预测结果。同时,还要建立监控系统来跟踪模型的性能,确保它随着时间的推移仍然准确。

-

应用:

- 目标营销:根据模型预测的购买概率,营销团队可以定制沟通策略,向那些更有可能购买的用户群体发送个性化的推广邮件或优惠券。

- 个性化推荐:利用用户行为数据,推荐系统可以向用户展示他们可能感兴趣的商品,提升用户体验,进一步增加转化率。

- 库存管理:根据用户对不同商品的喜好及其购买概率,公司能够更好地预测对哪些商品的需求将会增加,从而更有效地管理库存。

-

持续优化:

企业将不断收集新的用户数据,并周期性地重新训练模型以应对消费行为的变化。此外,公司可以运行A/B测试,以测试不同的营销策略,并根据测试结果进一步细化机器学习模型。

以上只是一个简化的应用案例,实际项目会远比这个复杂,涉及到的工作会更加细化。此外,企业在应用机器学习时还需要考虑数据隐私、安全性、伦理等问题,确保遵守相关法律法规,同时保护用户的个人信息。

7.3 机器学习的未来发展趋势

八、总结与展望

8.1 机器学习的局限性

8.2 未来的研究方向

8.3 学习资源推荐

以下是一些不同形式的机器学习相关资源的推荐

在线课程:

-

Coursera - Machine Learning by Andrew Ng

Andrew Ng的这门课程无疑是最受欢迎的入门级机器学习课程之一。它涵盖了机器学习的基本概念,算法,以及如何实践。 -

edX - Principles of Machine Learning by Microsoft

这门课程是微软提供的,更偏向于应用,学生将使用Python和R来学习如何实现机器学习解决方案。 -

Udacity - Intro to Machine Learning with PyTorch and TensorFlow

Udacity提供了两门关于机器学习的课程,一门专注于PyTorch,另一门专注于TensorFlow。 -

fast.ai - Practical Deep Learning for Coders

cette门课程更注重动手实践,教您快速上手深度学习项目。使用的是fastai库和PyTorch。

书籍:

-

“Pattern Recognition and Machine Learning” by Christopher M. Bishop

这本书提供了模式识别和机器学习的全面介绍,适合想要深入了解理论的读者。 -

“Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow” by Aurélien Géron

本书采用实用的方法,展示了如何使用Python中的Scikit-Learn、Keras和TensorFlow框架来实现机器学习。 -

“Python Machine Learning” by Sebastian Raschka and Vahid Mirjalili

这本书关注于使用Python进行机器学习和它在实际问题解决中的应用。 -

“Deep Learning” by Ian Goodfellow, Yoshua Bengio, and Aaron Courville

由业界知名专家撰写,这本书深入探讨了深度学习的各个方面。

论坛和社区:

-

Kaggle

Kaggle是一个数据科学竞赛平台,社区活跃,可以找到大量的数据集,参与各种项目挑战,并学习他人分享的代码和解决方案。 -

Reddit (r/MachineLearning)

Reddit上的机器学习板块是一个讨论最新研究成果、项目和问题的论坛。 -

Cross Validated (Stack Exchange)

这是一个有关统计学、数据分析、数据挖掘、机器学习等主题的问答网站。

数据集资源:

-

UCI Machine Learning Repository

这是机器学习研究的一个非常知名的数据集集合,适合实验和测试算法。 -

Google Dataset Search

Google提供的数据集搜索工具可以帮助寻找网络上的数据集。

会议和研讨会:

-

NeurIPS (Conference on Neural Information Processing Systems)

是机器学习和计算神经科学的顶级国际会议之一。 -

ICML (International Conference on Machine Learning)

是一个提供机器学习领域最新研究成果和相关教育资料的会议。 -

CVPR (Conference on Computer Vision and Pattern Recognition)

如果你对计算机视觉和模式识别特别感兴趣,这是一场重要的国际会议。

教程和博客:

-

Machine Learning Mastery by Jason Brownlee

这个网站提供了很多关于机器学习的实用指南和教程,适用于不同的技能水平。 -

Distill.pub

提供关于深度学习和机器学习的高质量、对新手友好的文章,用交互式视觉化来解释复杂概念。

软件和工具库:

-

Scikit-Learn (Python)

对于刚入门的数据科学家来说,这是一个强大且易于使用的机器学习库。 -

TensorFlow (Python)

谷歌支持的开源深度学习框架。 -

PyTorch (Python)

Facebook支持的开源深度学习框架,以其动态计算图和易于使用的高级自定义性著称。

以上资源覆盖了从初学者到经验丰富的从业者在学习机器学习过程中的需求。随着技术的不断发展,建议定期关注这些资源的最新动态。